生物は自分で動いて、そのときに何が見えるか、動きに応じてどんなふうに見えるものが変わるのか、を繰り返し経験しています。そのような自分の経験を通して人間がもっているような高度な知能を獲得するニューラルネットワークモデルについて近年盛んに研究が行われていますが、私たちはとくに自分が今どこにいるのかという認識がどのように生まれるのかを深層学習によってシミュレーションしています。ここではその中で行った実験について紹介します。

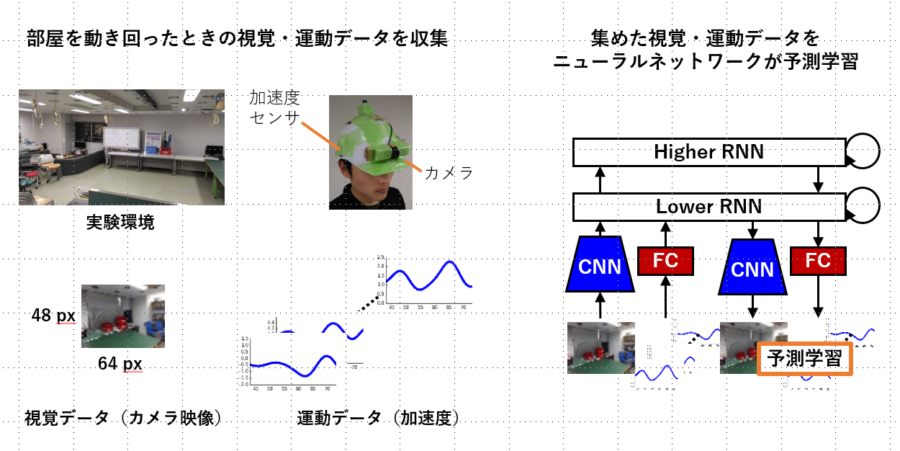

まず、下の図に示すような部屋の中を被験者に動きまわってもらい、そのときに見える映像を額に取り付けたカメラによって録画、また、動きの情報も加速度センサによって収集しました。

収集した視覚と運動のデータを図の右側に示すニューラルネットワークモデルに学習させます。学習は未来の視覚データと運動データがどのように変化するかを予測する予測学習です。

とくに、運動データだけを入力したときに視覚データがどのように変化するかを予測させる学習も行いました。つまり、目をつぶって歩いたときに、目を開けば見えるはずの景色がどのように変わるのか、を学習します。

結果として、下の動画に示すように、目をつぶって歩いたときにも本来見えるはずの映像を予測することができるようになりました。これはつまり部屋の中の映像が深層学習モデルの内部でシミュレートできるようになったということです。

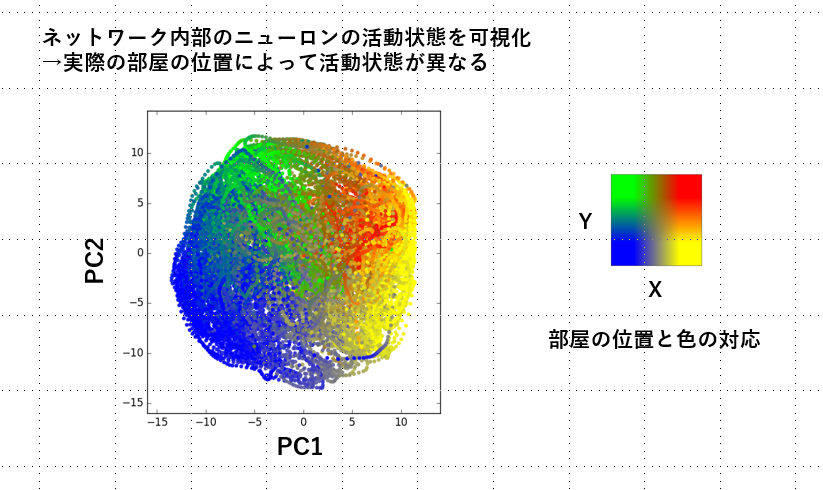

さらに、下の図はネットワーク内部のニューロンの活動を可視化したもので、これを見ると、ニューロンが部屋の中での位置に応じて活動していることがわかりました。これは、深層学習モデルの中に自分の部屋の中での位置という認識が生まれたと考えることができます。

[2]では、同様なニューラルネットワークモデルによって目的地に向かう空間ナビゲーション行動が実現できることも示しています。

[1] Noguchi, Wataru, Hiroyuki Iizuka, and Masahito Yamamoto.

"Cognitive map self-organization from subjective visuomotor experiences in a hierarchical recurrent neural network."Adaptive Behavior 25.3 (2017): 129-146. [2] Noguchi, Wataru, Hiroyuki Iizuka, and Masahito Yamamoto.

"Navigation behavior based on self-organized spatial representation in hierarchical recurrent neural network."Advanced Robotics 33.11 (2019): 539-549.